はじめに

今回は、OpenAI からリリースされた Whisper をマイク入力から実行できるようにした Whisper_mic のデモを実行していきます。

Whisper の github はこちらです。

Whisper_mic の github はこちらです。

前提条件

前提条件は以下の通りです。

- Python == 3.10.6

- Windows11

ffmpeg のインストール

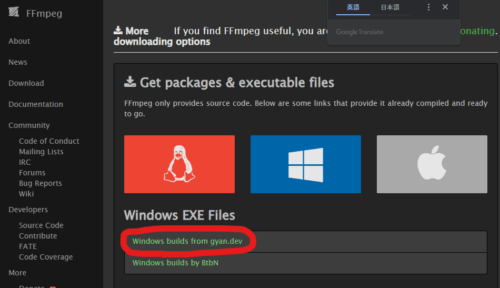

まずは、こちらのページに移動します。

Windows builds from gyan.dev をクリックします。

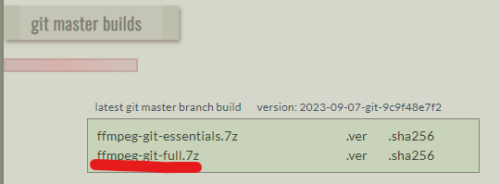

ffmpeg-git-full.7z をクリックして、ダウンロードします。

解凍したら、フォルダ名を Ffmpeg として、C:\Program Files に配置します。

続いてパスを通します。

C:\Program Files\Ffmpeg\bin を PATH に設定してください。

設定後、ターミナルを起動して

ffmpeg -versionを実行して

ffmpeg version 2023-09-07-git-9c9f48e7f2-full_build-www.gyan.dev Copyright (c) 2000-2023 the FFmpeg developers

built with gcc 12.2.0 (Rev10, Built by MSYS2 project)上記のように表示されていればインストール完了です。

Whisper のインストール

非常に簡単です。

python -m pip install -U openai-whisperバージョンを確認しておきます。

python

>>> import whisper

>>> whisper.__version__

'20230314'whisper == 20230314 です。

Whisper_mic のプログラム変更

git clone https://github.com/mallorbc/whisper_mic.git

cd whisper_mic/whisper_miccli.py 8 行目

from whisper_mic.whisper_mic import WhisperMic

↓

from whisper_mic import WhisperMicwhisper_mic.py 15 行目

from whisper_mic.utils import get_logger

↓

from utils import get_loggerwhisper_mic.py 40 行目

self.audio_model = whisper.load_model(model, download_root=model_root).to(device)

↓

self.audio_model = whisper.load_model(model).to(device)whisper_mic.py 109 行目

result = self.audio_model.transcribe(audio_data)

↓

result = self.audio_model.transcribe(audio_data, language='japanese')Whisper_mic の実行

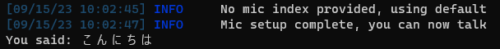

早速、実行してみます。

python cli.pyデフォルトでは、base モデルが使用されます。

その他のモデルは、tiny, base, small, medium, large があります。

無事に認識できています!

medium で実行

medium モデルで実行するときは、以下のコマンドです。

python cli.py --model mediumおわりに

今回は、OpenAI が 開発した音声認識AI Whisper をマイク入力から実行できるようにした Whisper_mic について説明しました。

次回は、高速化された Whisper である faster_wisper を Whisper_mic に組み込んでいきます。

コメント